Dalla fisica classica alla fisica delle particelle

I fondamenti erano chiari e comprensibili: molte cose si fondavano su una eccellente descrizione di tipo meccanico mediante “fluidi” continui e conservati (indistruttibili); il calorico, che fluiva da corpi caldi a corpi freddi, l’elettricità, la misteriosa sostanza eterea che riempiva il cosmo ed era suscettibile di vibrare per sollecitazioni elettromagnetiche. “Gli atomi? Chi li ha mai visti?” diceva Ernst Mach, spalleggiato da Duhem e Ostwald nella convinzione che si dovessero rigettare idee che non fossero anticipate dall’osservazione. Insomma, la fisica classica era sostenuta da un acceso conservatorismo, forse giustificato dal fatto che rappresentasse l’elegante coronamento di uno sforzo intellettuale collettivo senza precedenti. Il povero Boltzman, che osò andare controcorrente, si tolse la vita per disperazione dopo averci lasciato un’anticipazione illuminante. La situazione è ben descritta in una celebre fiction dello storico McCormack, Incubi notturni di un fisico classico.

Eppure, quella fisica ottocentesca, che sembrava scoppiare di salute, morì in pochi anni; naturalmente, morì come muoiono le scienze molto evolute, lasciando gran traccia di sé negli eredi. Max Planck riuscì a fare una teoria soddisfacente del corpo nero, introducendo la celebre costante universale che, da allora, porta il suo nome. Jean Perrin mostrò senza ombra di dubbio che gli atomi esistono, e misurò ingegnosamente il famoso numero di Avogadro, chiave di volta di ogni teoria atomica della materia, come la meccanica statistica inventata dal povero Boltzman. Nel 1905, Einstein entrò in scena con tre lavori fondamentali, uno dei quali legato alle misure di Perrin sulle fluttuazioni termiche, un altro al cosiddetto effetto fotoelettrico e un terzo alla “relatività speciale” che intaccava le nozioni classiche (i presunti a priori!) di spazio e tempo. Niels Bohr propose un modello atomico che rendeva conto delle righe spettrali degli atomi e mostrava l’inadeguatezza dell’elettromagnetismo classico al livello microscopico: e non era che il preludio di ben più rivoluzionarie concezioni. Ernest Rutherford convalidò il cosiddetto modello “planetario” degli atomi usato da Bohr, mostrando che la massa di un atomo è concentrata in un nucleo centrale a cui si devono attribuire i fenomeni di radioattività: il nucleo è già centomila volte più piccolo di un atomo: e appena qualche anno prima erano ancora in dubbio gli atomi stessi!

Un nuovo mondo microscopico: la fisica delle particelle

Quei piccoli fenomeni “marginali” stavano sconvolgendo i fondamenti della fisica classica: questa stava rivelandosi come niente più di un modello adeguato a descrivere fatti al livello detto “macroscopico”, cioè – grosso modo – delle dimensioni corrispondenti a ciò che è direttamente percepibile a un essere umano. Nei primi trenta anni del secolo vi fu così una vera e propria escalation delle idee della fisica: la meccanica di Newton fu doppiamente soppiantata, prima dalla relatività (sia speciale che generale) di Einstein e poi dalla meccanica quantistica di Heisenberg e Schrödinger, seguite dalla meccanica quantistica relativistica di Dirac. Il mondo dei fisici si riempì di particelle dette “subatomiche” perché riconosciute dapprima come costituenti dell’atomo: gli elettroni, i nuclei e i protoni, seguiti dai neutroni come riconosciuti costituenti dei nuclei; ma poi, come previsti dalla teoria di Dirac, i positroni, primo e straordinario esempio di particella che non fa parte della materia stabile ma che può essere prodotta da radiazioni energiche, per esempio i fotoni, genialmente preconizzati da Einstein per interpretare l’effetto fotoelettrico (l’espulsione di elettroni da metalli irradiati), imprevedibili nell’elettromagnetismo classico.

Incomincia qui ad accadere che la rappresentazione dei fenomeni “microscopici”, cioè a livello che va dagli atomi in giù, si allontana sempre più dal senso comune, si fa astratta e richiede strumenti formali di difficile uso. Ma come dubitare della realtà delle previsioni se una equazione come quella di Dirac predice la possibile esistenza di una particella (la si chiamerà, per la precisione, un’antiparticella) come il positrone, partner di carica elettrica opposta dell’elettrone, primo esempio di antimateria, che poi viene trovato in una reazione provocata da radiazioni cosmiche, esattamente come descritto? Le particelle non sono nemmeno più corpuscoli materiali come li si era pensati sino ad allora, ma sono ambigui ibridi di corpuscoli e onde, difficili da immaginare a una mente non coltivata con strumenti matematici appropriati.

Estinzioni eccellenti e boom di scoperte

Lo spazio e il tempo mutano e si allargano e riempiono di cose nuove e inimmaginabili con la fisica classica. L’etere muore quasi sul colpo; ne escono sconvolti l’idea di simultaneità, che perde il suo carattere assoluto, e l’idea di durata, che con il “paradosso dei gemelli” assume un inquietante carattere dipendente dall’osservatore. Quando Bruno Rossi mostrerà che una certa particella instabile (il mesone detto mu – come la lettera greca), ma poi anche ogni altra particella instabile, ha una vita media la cui durata dipende dalla velocità rispetto all’osservatore, nessuno avrà più dubbi sul fatto che il tempo non è uguale per tutti. Hubble scopre che fuori della Via Lattea c’è una miriade di galassie che sembrano allontanarsi da noi con velocità che aumenta con la distanza: l’universo diviene immenso rispetto a ciò che prima si riteneva, anzi, immenso e assai longevo, almeno dieci miliardi di anni.

La scoperta di un nuovo pianeta, negli anni ‘30, il piccolo e lontano Plutone (che, stando a notizie di questi giorni, potrebbe non essere l’ultimo) appare oggi tuttavia poca cosa rispetto agli incredibili mostri astrofisici trovati negli ultimi trent’anni: le misteriose quasar, le pulsar, le stelle di neutroni, i buchi neri. La relatività generale soppianta in questo campo qualsiasi concezione classica newtoniana; confermata ottant’anni fa da osservazioni delicate come quelle sulla deflessione dei raggi luminosi che passano in prossimità del disco solare o dalla precessione del perielio di Mercurio, ormai rende conto di fatti cosmici come l’effetto di lente gravitazionale, il big bang e la radiazione di fondo primordiale, i sistemi doppi stella-buco nero e così via.

Ovviamente, i fenomeni atomici inaccessibili alla fisica classica ma con manifestazioni macroscopiche si moltiplicano incessantemente: alle basse temperature, dopo le teorie soddisfacenti dei calori specifici dei solidi secondo la generalizzazione delle idee di Boltzman, Gibbs e tanti altri, ci si imbatte nei superfluidi (gli isotopi dell’elio allo stato liquido), nei superconduttori, che conosceranno varianti anche a temperature sempre più vicine a quella ambiente; verranno poi i semiconduttori, elementi impareggiabili di circuiti elettrici e base di innumerevoli applicazioni tecnologiche; ma anche tecniche apparentemente meno esotiche, come quella delle risonanze magnetiche, specie nucleari ma anche elettroniche, serviranno equamente la fisica dei fondamenti e le applicazioni, particolarmente quelle mediche. Grande impatto avranno le sorgenti di radiazioni coerenti, il maser e il laser, preconizzati da Einstein in una sua variante della teoria di Planck del corpo nero: il solo elenco degli usi scientifici e delle applicazioni di queste “scoperte” riempirebbe molte di queste pagine.

La fisica atomica va alla guerra, e pochi disertano

Con la scoperta del neutrone (Chadwick, 1932) si apre un capitolo assai problematico della nuova fisica. Già i coniugi Joliot-Curie avevano scoperto esempi di trasmutazioni nucleari indotte dal bombardamento di nuclei mediante particelle dette alfa (a), in realtà nuclei di elio emessi in decadimenti radioattivi di elementi pesanti; Enrico Fermi e il celebre gruppo di via Panisperna rendono sistematico il lavoro di produzione di nuovi elementi radioattivi per bombardamento di neutroni lenti, che si dimostrano assai più efficaci delle a dei Joliot-Curie. Il gruppo di via Panisperna soffre di varie peripezie nell’Italia fascista che ben presto entrerà in guerra: il gruppo si disperde, la persecuzione razziale o politica porta i componenti in paesi meno rischiosi. Intanto Hahn e collaboratori, usando neutroni lenti, scoprono la fissione dell’uranio U235 e di lì a capire che il passo per produrre combustibili nucleari o esplosivi senza precedenti è breve.

La guerra induce a intensificare le ricerche: i tedeschi, sotto la guida di Heisenberg, (forse deliberatamente) non arrivano a risultati concreti; Fermi attiva un reattore nucleare a Chicago, con i suoi collaboratori americani, già nel 1942. Parte il progetto Manhattan, che nel 1945 culminerà nel bombardamento nucleare di Hiroshima e Nagasaki. La fisica si imbatte nella guerra e ne condivide le responsabilità militari collaborando a uno sviluppo di tecnologie belliche che non conoscerà più sosta. Molti fisici vivono queste vicende in preda a vere e proprie crisi di coscienza; ma molti altri non rifiutano la loro collaborazione.

Dalla guerra nasce la Big Science

Chi ha incominciato come fisico nucleare immediatamente prima della seconda guerra mondiale, si converte molto spesso in fisico dei raggi cosmici oppure continua la sua attività dedicandosi alle ricerche effettuate con i fasci di particelle energiche prodotte da acceleratori. Gli acceleratori costano: la loro energia cresce progressivamente nel tempo; se i primi costruiti, negli anni ‘30, accelerano particelle cariche (generalmente protoni, talvolta elettroni) fino a qualche milione di Volt (MeV), oggi siamo ormai a diecimila miliardi di Volt, con impianti grandi decine di chilometri.

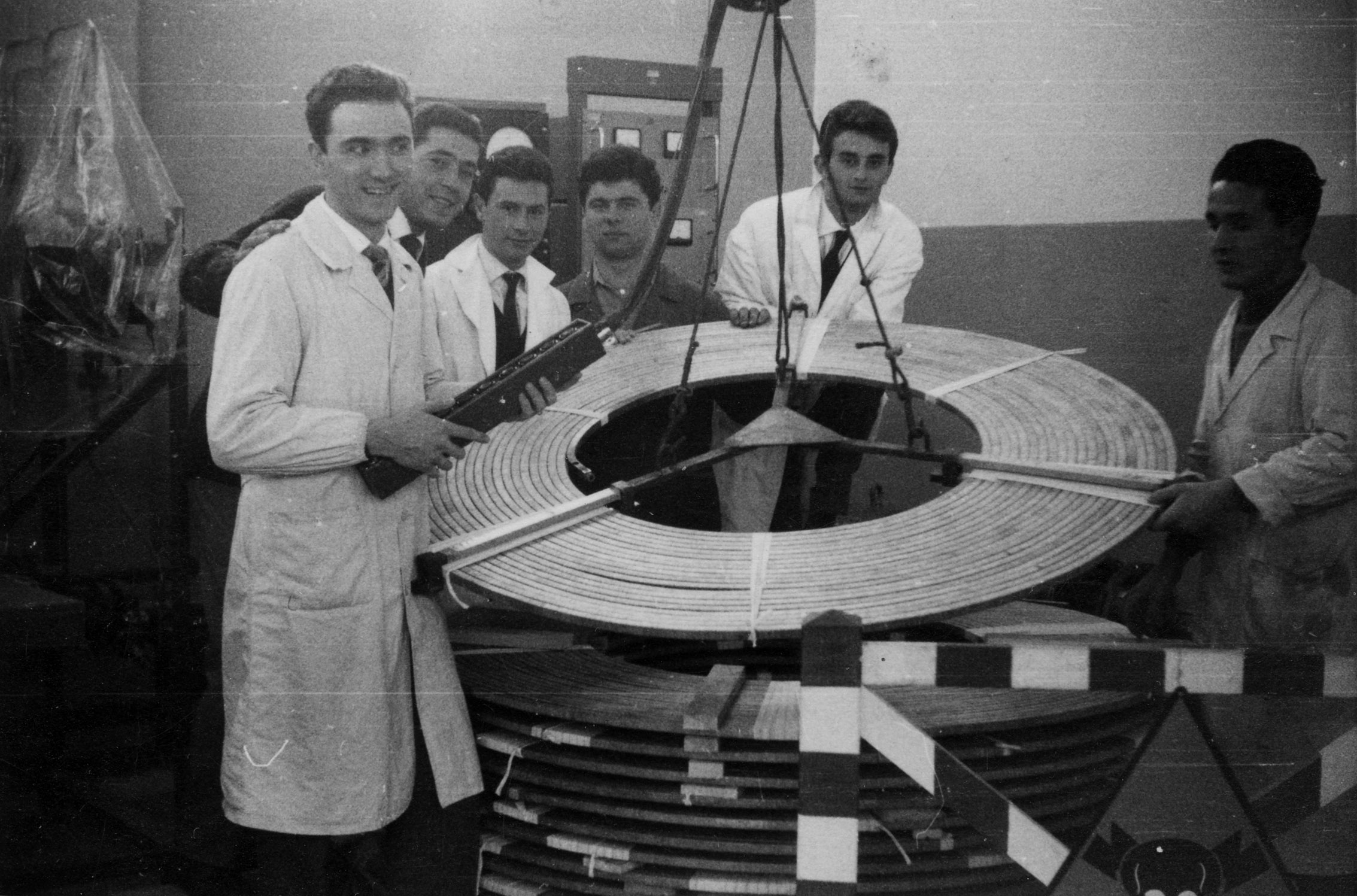

Dopo lo sviluppo di ingegnosi impianti acceleratori con guida magnetica dei fasci (ciclotroni, betatroni, sincrotroni), una svolta sensazionale è avvenuta nel 1960 con la sperimentazione del primo prototipo di anello di collisione, l’anello AdA (Anello di Accumulazione) ideato da Bruno Touschek presso i Laboratori Nazionali di Frascati: quel positrone, che appena trent’anni prima appariva una “particella di carta”, ora è addirittura proiettile e bersaglio ad un tempo in un fascio di un acceleratore: se questo non basta a rendere l’idea di come la fisica abbia addirittura prodotto una parte normalmente invisibile di universo, nient’altro potrà renderla con altrettanta forza.

Il mondo delle particelle elementari si è riempito di strani “individui”, oggetti che cambiano natura nel tempo, distinguono la destra dalla sinistra, producono altri oggetti estremamente instabili, alcuni assai pesanti, altri senza massa o quasi; ma poi, che sarà mai la massa di questi oggetti? Che cosa la determina? E perché in certi casi queste “particelle” mostrano certe proprietà e in certi altri proprietà affatto diverse? E che cosa sarà la teoria generale di questi ultimi costituenti? I quark? I mesoni W e Z? Le teorie sono così difficili da interpretare che il numero di esperti in “supersimmetrie” o in “superstringhe” si conta su poche mani, né sarebbe qui possibile accennare a che cosa queste teorie dicono. Il più grande acceleratore oggi in costruzione, lo LHC (Large Hadron Collider) di Ginevra entrerà in funzione dopo l’anno 2005 e forse fornirà qualche risposta.

Caccia alla massa mancante, la fisica delle astroparticelle

Andrebbe sottolineato che si sta verificando una rapida convergenza tra astrofisica e cosmologia da una parte e fisica delle particelle elementari dall’altra: la nuova specialità si chiama già “astroparticelle” (astroparticles). Gli astrofisici hanno bisogno di identificare ciò che porta la “massa mancante” nel bilancio gravitazionale dell’universo, e sperano in qualcosa come una particella con massa ma debolmente interagente per via non gravitazionale. I fisici cercano di farsi un’idea di ciò che avvenne nelle condizioni estreme dell’inizio dei tempi. Ma la teoria della relatività generale di Einstein non si è lasciata quantizzare, e questo sarà forse il problema più acuto della fisica del 2000. Checché ne dicano le Cassandre che, oggi come 100 anni fa, pensano che la fisica stia per chiudere non avendo “più nulla da scoprire”.