Se ne fa, da tempo, un gran parlare, ma le problematiche relative allo sviluppo dei veicoli autonomi non sono meramente tecniche. Le implicazioni etiche relative all’utilizzo delle macchine autonome sono enormi e vanno considerate accuratamente per programmare queste automobili prima del loro arrivo su scala globale. Perché se è vero che i veicoli autonomi non bevono alcol e non si addormentano il rischio incidenti non è azzerato, e in alcune situazioni i veicoli potrebbero trovarsi di fronte a grandi dilemmi. Un esempio su tutti: come dovrebbe essere istruita ad agire una macchina in una situazione in cui si trovi a dover scegliere se salvare la vita di uno o più pedoni o quella dei suoi passeggeri?

La domanda è tutt’altro che banale, chiamando in causa questioni di sicurezza. Per capire come si dovrebbe rispondere a quesiti (situazioni) del genere, e più in generale per testare il terreno in materia, il team composto da Jean-François Bonnefon della University of Toulouse Capitole insieme a due colleghi americani ha condotto una serie di sondaggi online durante lo scorso anno chiedendo ai cittadini (residenti Usa in questo caso) come avrebbero voluto che si comportassero dei veicoli autonomi in alcune situazioni.

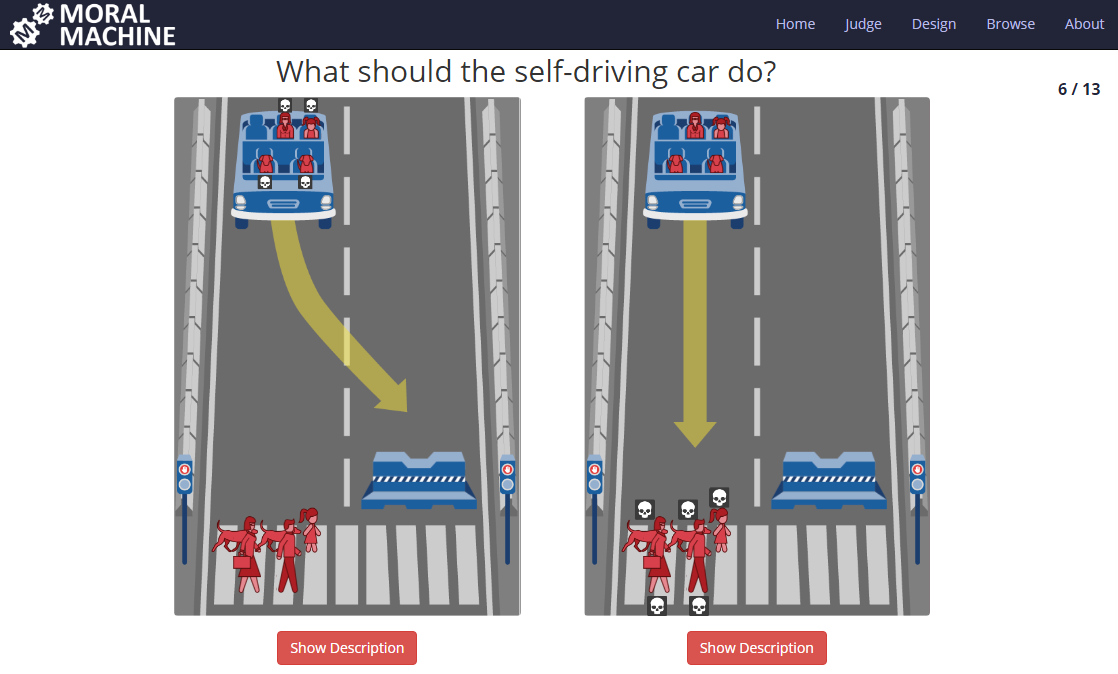

Per farlo i ricercatori si sono serviti di alcuni scenari disponibili su un sito creato da loro (http://moralmachine.mit.edu/). E le risposte hanno mostrato alcune inconsistenze in materia.

Per esempio, in situazioni di estremo pericolo la logica preferita è quella che mira ad evitare il danno maggiore, ovvero se si tratta di scegliere tra salvare la vita a un passeggero o quella di dieci pedoni, i pedoni vengono prima. Ma, al tempo stesso, gli intervistati hanno dichiarato che sarebbero meno propensi a comprare o usare un veicolo programmato ad agire in questo modo, specie se fossero coinvolti anche i propri famigliari. In generale le persone vorrebbero veicoli autonomi il più possibile pedone-friendly, spiegano gli scienziati, ma non per quelli su cui siederebbero loro o i loro famigliari. Come a dire: preferiamo che gli altri guidino veicoli guidati da una logica del minor danno e pedone-friendly, ma per noi no. Una sorta di “dilemma sociale” come lo hanno chiamato i ricercatori pubblicando il loro lavoro sulle pagine di Science: la maggior parte delle persone vorrebbe vivere in un mondo in cui l’uso delle macchine faccia il minor numero di vittime, ma agendo tutti nel proprio interesse si potrebbero creare in realtà condizioni meno sicure per tutti.

“Per ora, non sembra esserci un modo per sviluppare algoritmi che concilino i valori morali e l’interesse personale”, scrivono gli autori: “Capire come costruire veicoli autonomi etici è una delle sfide più spinose nel campo dell’intelligenza artificiale oggi. Mentre stiamo per rendere disponibili milioni di veicoli autonomi, una considerazione seria sulla moralità degli algoritmi che li guidano non è mai stata più urgente. Il nostro approccio data-driven sottolinea come il campo dell’etica sperimentale può fornire conoscenze fondamentali nei confronti delle norme che le persone si aspettano da algoritmi di guida autonoma”.